Forward propagation in a deep network

Getting your matrix dimensions right

Why deep Representations?

deep neural network가 shallow network 보다 더 쉽고 간편하게 계산 가능

Building blocks of deep neural networks

forward propagation에서 layer마다 W[l],b[l]으로 a[l]을 계산하여 yhat까지 계산함. Z[l],W[l],b[l]도 추가적으로 계산하여 저장해놓음.

backward propagation에서는 da[l]으로 dw[l],db[l],da[l-1]을 계산하면서 W[l],b[l]을 update 함.

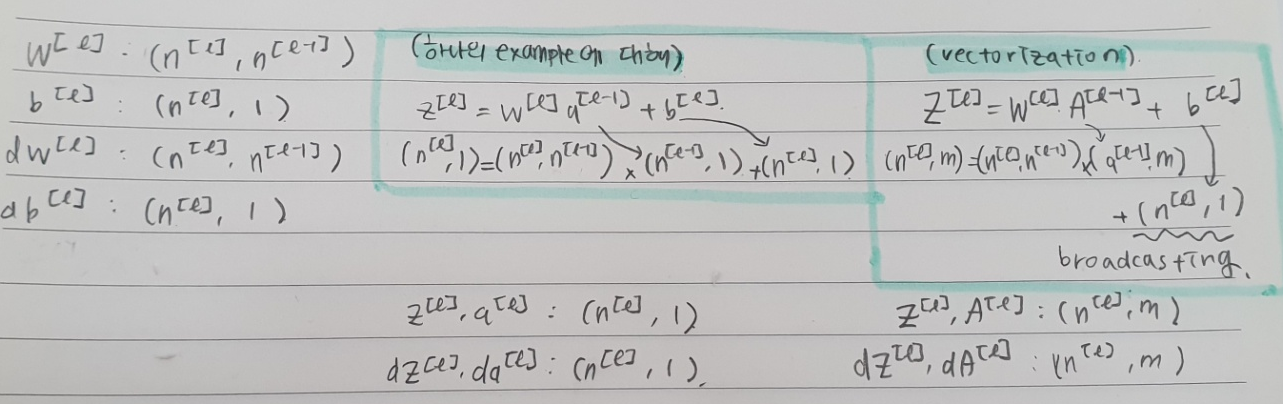

Forward and Backward propagation

왼쪽은 하나의 example에 대해, 오른쪽은 vectorized version에 대해 da[l]이 주어졌을 때 dZ[l],dW[l],db[l],dA[l-1]을 계산한 것이다.

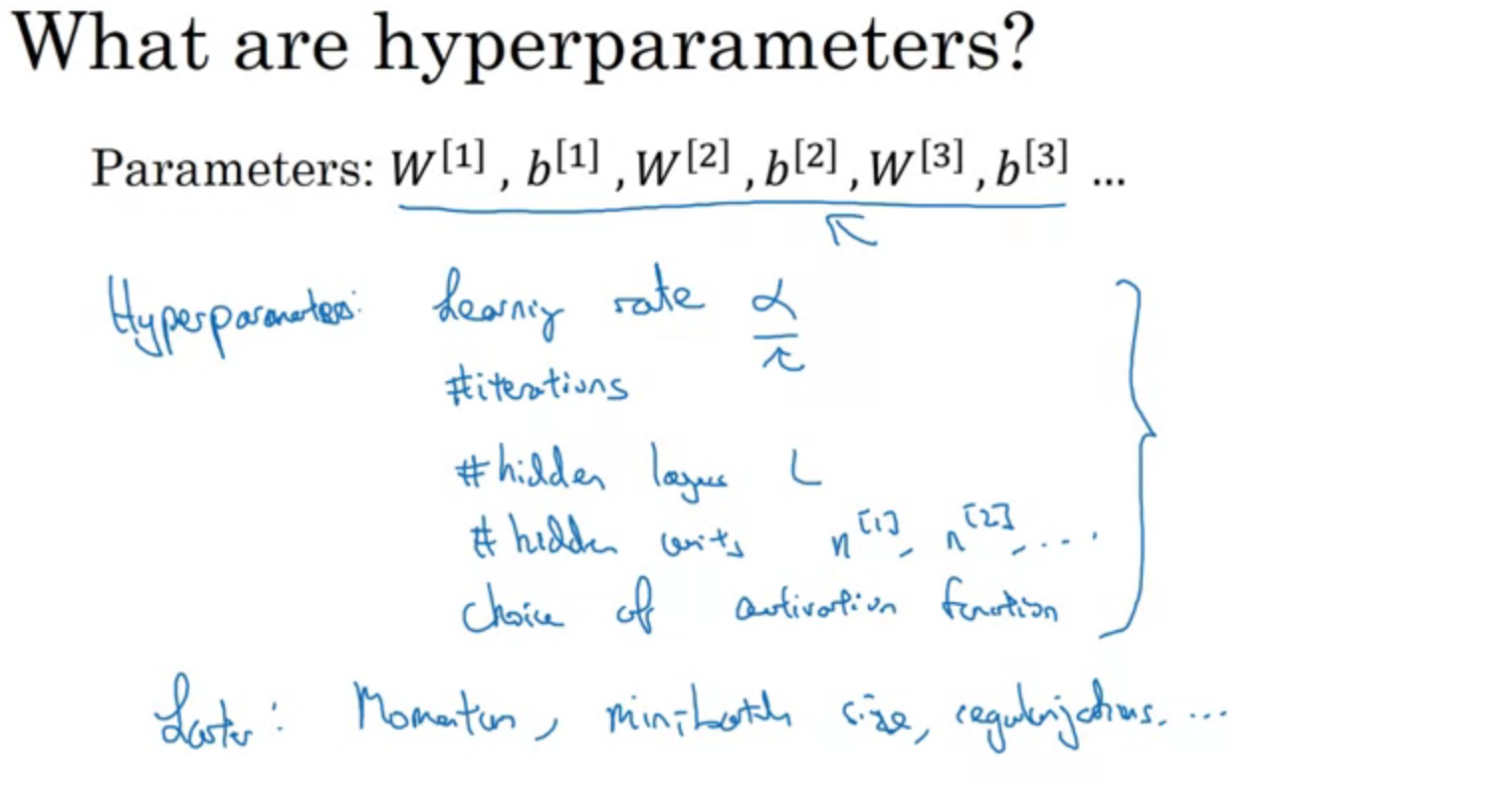

parameters vs hyperparameters

hyperparameter는 parameter에 영향을 준다. 여러가지 값들로 변형을 해가면서 최적의 hyperparameter을 찾는 과정이 필요하다.

Summary

'딥러닝 > DeepLearning.ai' 카테고리의 다른 글

| 4주차. Programming: Deep Neural Network - Application (0) | 2021.02.07 |

|---|---|

| 4주차. Programming: Building deep neural network (0) | 2021.02.07 |

| 3주차. Programming assignment (0) | 2021.02.05 |

| 3주차. Shallow Neural Network (0) | 2021.02.04 |

| 2주차. Programming: Logistic Regression with Neural Network mindset (0) | 2021.02.03 |